FALTA UN POCO PARA QUE TERMINE 2016, pero no tengo dudas de que mi serie del año es Billions. Para bien de todos, la acaban de subir al Netflix local, lo que hará que la vea de nuevo y de paso quede atrapada en la furia que me desvela desde chica: la oscuridad del poder absoluto y sus injusticias. En Billions, el imperio es del rey de los fondos especulativos Bobby “Axe” Axelrod (en la cara de piedra y los ojos translúcidos de Damien Rice, ex Homeland), un tipo lindo, con esposa escandinava, oficinas de revista de decoración y una varita mágica para convertir la plata en mucha, mucha plata. Todo lo que lo rodea responde a él con devoción o miedo. En el medio, no se sabe: su mente es tan sombría que ni los que vemos la serie sabemos qué piensa ni cómo resuelve hacer su mal. Frente a él, el fiscal general de Estados Unidos, Chuck Rhoades (un Paul Giamatti neurótico, sadomasoquista, woodyalenesco), que busca cómo, con una ley que no previó un mundo así de despiadado, puede atrapar al ladrón. Porque claro, Axe es un ladrón, pero de los nuevos, de los que se esconden tras su marketing de beneficencia, bonos fabulosos de fin de año a sus empleados, jets privados para ir a un concierto de rock en el día con sus amigos, tapas de revistas. ¿Dónde, cómo y cuándo puede un delincuente así ser juzgado en un mundo donde todos quieren ser como él?

Billions es la metáfora del mundo hoy. Donde nosotros, el 99%, trabajamos, amamos, buscamos nuestros pequeños éxitos, mientras el 1% que tiene cada vez más se lleva la recompensa, y además no nos dejan ver cómo. La respuesta es simple: a más poder, menos capacidad de control. Y si el poder es el de la empresa privada, más difícil aún. Todavía, cada tanto, las dictaduras caen. ¿Pero quién se mete con las grandes corporaciones, que además viven de nosotros, de nuestro trabajo y de nuestros datos? O, como dice Assange: somos individuos cada vez más transparentes y el poder cada vez más oscuro.

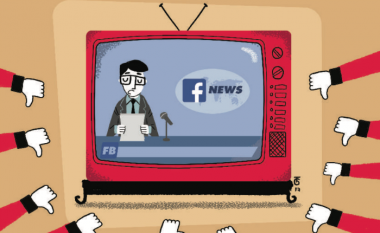

Uno de esos poderes oscuros del mundo es el puñado de compañías tecnológicas que controlan nuestras vidas. Detrás de su opacidad, deciden lo que vemos, o lo que no vemos, sin decirnos. Este año, sumaron nuevos y peligrosos casos donde sus sentencias autocráticas jugaron con la democracia. Y sin que nadie las controle.

En septiembre, la policía blanca de Charlotte mató a Keith Scott, negro, frente a su esposa. Todo grabado en video: un asesinato. Durante dos días, las protestas convocadas por el movimiento Black Live Matters provocaron revuelos en esa y en otras ciudades. Mientras eso ocurría, Facebook tomó una decisión: activar el “Safety Check”, una función que la empresa había desarrollado en 2014, que permitía decir “Estoy a salvo” en caso de encontrarse en una zona de “desastres o crisis”, es decir, de terremotos, atentados terroristas como el del teatro Bataclan de París o tiroteos masivos como el de Orlando. En este caso, Facebook decidió que un grupo de ciudadanos reclamando justicia era una “catástrofe” e hizo que su algoritmo se activara automáticamente. Con eso, los colocó en el mismo nivel que los terroristas de ISIS.

Con pocos días de diferencia, “el algoritmo” Facebook tomó otra “decisión editorial” que también se pareció a la censura: decidió eliminar la histórica foto de una niña vietnamita desnuda escapando de un ataque con napalm durante la guerra con Estados Unidos. La imagen había sido compartida por un escritor noruego en su muro, pero desapareció ya que contenía un desnudo, o al menos así fue leído por la fórmula de Mark Zuckerberg, que determina qué se queda y qué se va de su universo, la red social más popular del mundo. Inmediatamente, los noruegos comenzaron a reproducir la foto en forma de protesta, el país expresó su indignación a través de sus ministros y la comunidad internacional repudió la censura. Facebook, entonces, se retractó y repuso la foto, tras “escuchar los pedidos de sus usuarios” y reconocer el “carácter de imagen emblemática de importancia histórica” a la foto de Nick Ut, de 1972, que había ganado un Pulitzer. La catarata de análisis y editoriales de medios fue inmediata: “Facebook necesita un editor de noticias”, coincidieron. “Facebook necesita pensar muy seriamente qué significa ser un medio”, dijo Emily Bell, directora del Tow Center para el Periodismo Digital de la Facultad de Periodismo de Columbia. Y advirtió: “Si no, este problema se va a repetir”.

Si nos informáramos solo por el algoritmo de Facebook –como probó Megan Charpentier de The Guardian durante septiembre–, el resultado sería saber mucho de Pokémon Go, el cumpleaños de Richard Gere, el iPhone 7, la pérdida de peso de la actriz Gabourey Sidibe y el pecho tapado con un corazón en el Snapchat de Kaley Cuoco. Si fuera por Google, tampoco sabríamos dónde queda o cómo llegar a Palestina. Durante agosto, un grupo de periodistas detectó que se había eliminado la etiqueta de esa nación de Google Maps, la aplicación de mapas más popular del mundo, y organizaron una protesta en las redes sociales bajo el hashtag #PalestineIsHere (#PalestinaEstáAcá). Tras varios días, la compañía de Mountain View tuvo que responder, y aseguró que el país no se había eliminado (aunque las capturas de pantalla de los usuarios dijeran lo contrario). Sin embargo, Google admitió que, por un “fallo en su sistema”, sí se habían suprimido las etiquetas de Cisjordania y la Franja de Gaza. Tras decir que los cambios no habían sido “intencionales”, prometieron volver a la normalidad el mapa. Aun así, la posibilidad estaba demostrada: si la aplicación de mapas utilizada por un tercio del planeta decidía tachar un país al menos por un día, ese lugar desaparecía.

Todos los casos plantean la misma pregunta: ¿Si creamos y vamos perfeccionando herramientas para controlar a la política de sus abusos, por qué no podemos hacerlo con las empresas privadas? Tal vez, la respuesta, sea fundar, desde la misma política, esas herramientas, antes de que las multicompañías dominen (del todo) el mundo.

Publicada en la revista Brando, en noviembre de 2016.