Plataformas y censura: De la opacidad a la transparencia

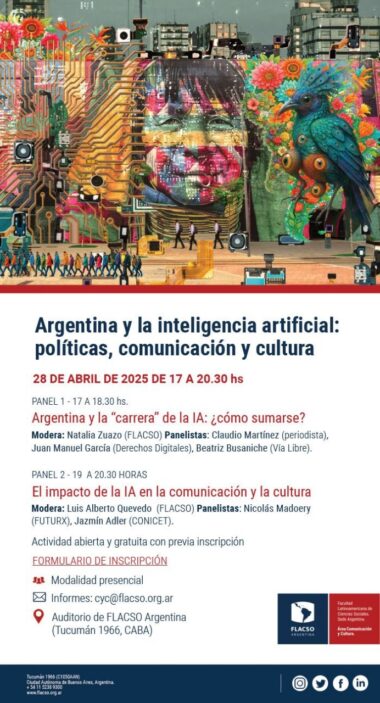

Por Natalia Zuazo

A pocos días de iniciarse la invasión de Rusia a Ucrania, las corporaciones digitales líderes de la industria mundial -casi todas con sede en Occidente- iniciaron una serie de medidas para aislar al gobierno de Vladimir Putin. Se restringió la publicidad en medios en Facebook, los videos de YouTube (de Google), y empresas como Apple, Microsoft, Netflix restringieron servicios.

La empresa de origen chino Tik Tok, por otro lado, restringió sus operaciones en Rusia respuesta a una nueva ley del gobierno de Putin para sancionar con hasta 15 años de prisión a los responsables de difundir información falsa.

Entre las medidas que dejaron a los ciudadanos del mundo con limitaciones en su acceso a la información, una en especial fue discutida. Twitter decidió marcar con la etiqueta “medios afiliados al gobierno” a periodistas y colaboradores de medios rusos como RT (Russia Today) y Sputnik. Rápidamente, organizaciones de derechos humanos y asociaciones de periodistas alertaron sobre una medida. Por lo pronto, era algo desproporcionada y opaca en sus criterios. La equiparación entre medios de comunicación y trabajadores de prensa también advirtió sobre la confusión de una medida tomada sin la revisión de los mínimos estándares internacionales de libertad de expresión y de prensa.

¿Qué criterios se habían tomado para el señalamiento realizado además sin posibilidad de apelación durante días hacia la plataforma? En documentos públicos, desde 2020, la compañía venía avanzando en etiquetar a medios “afiliados directa o indirectamente a un actor estatal” de ciertos países del mundo. Entre ellos, RT y Sputnik. En sus comunicaciones dejaba en claro que no marcaría la “afiliación estatal” a la BBC inglesa y la National Public Radio norteamericana, ya que estos medios garantizaban “independencia editorial”. Nada más decía de cualquier otro medio, de Occidente o de otro país: el resto quedaba a discrecionalidad de una regulación imprecisa.

Días después, los periodistas señalados vieron que la etiqueta desaparecía. La empresa tampoco ofreció explicaciones. La crisis había pasado y la empresa volvía a la normalidad. ¿Pero qué es la normalidad para las plataformas digitales sino moderar los millones de contenidos por segundo que se publican?

Trabajo full time

Solemos pensar que las plataformas de redes sociales tienen en la moderación de contenidos un trabajo extra. Algo que hacen “al terminar el día”, fuera de horario, como sacar la basura para tener la cocina limpia o hacer una clase de yoga para descansar mejor. Sin embargo, como señala el investigador estadounidense Talerton Gillespie, esto es justamente al revés: moderar es el trabajo central de las plataformas.

Google, Amazon y Facebook toman millones de decisiones de moderación por día, desde las más sencillas hasta las más complejas. A través de sus algoritmos priorizan contenidos que otros publican. Los muestran con más o menos frecuencia de acuerdo a interacciones o de acuerdo a decisiones publicitarias (con las que ganan dinero). También, para hacer que los espacios digitales sean más tolerables para sus usuarios, evitan que haya publicaciones que (de acuerdo a cada país, región o circunstancia) resultan ofensivas para las comunidades. Incluso, se ocupan de lidiar con todo tipo de delitos online. Ordenan un espacio creciente de discursos de odio, raciales, de género.

Desde 2016, también intervienen en un fenómeno tan difícil de determinar como sujeto a problemas: la “desinformación”. Con la victoria de Donald Trump, el Brexit y en 2018 la investigación de Cambridge Analytica, las redes sociales se convirtieron en el chivo expiatorio de cualquier falsa noticia del mundo. Las plataformas, en especial Facebook, comenzaron a recibir el mayor peso como las divulgadoras de operaciones falsas, como la mentira no hubiera circulado antes en operaciones o en medios tradicionales. Lo mismo ocurrió durante la pandemia: la moderación frente a las campañas campañas anti vacunas o anti covid necesitaron reforzarse de manera acelerada en las redes.

Con todo este trabajo, es claro que moderar y definir lo bueno y lo malo en las redes no puede -de ninguna forma- ser un trabajo circunstancial para las empresas. De hecho, las compañías dedican enormes recursos económicos y humanos (propios y de empresas tercerizadas) a ordenar un sinfín de posteos, fotos y videos. Lo hacen, a grandes rasgos, con medios automatizados (programas, robots que detectan por ellos) y con medios no automatizados (humanos y humanas que revisan estos millones de pixeles, caracteres y fotogramas). También, para ello, cuentan con la ayuda (más o menos interesada) de los usuarios que envían denuncias cuando consideran que algún contenido, persona, foto o video no debería permanecer en la red. Pero siempre son ellas las que determinan el criterio final de lo que debe quedar y cómo.

Lo bueno y lo malo

¿Cómo se hace, en un medio planetario como internet, para decidir qué queda y qué no? El gusto de los consumidores es subjetivo. Las culturas distintas. Las posiciones ideológicas y afectivas determinan mucho más lo que denunciamos en una red social que una supuesta racionalidad. En cierto punto, el mundo entero, al mismo tiempo, le pide a las plataformas que decidan sobre esos afectos y efectos de lo que ve en línea. Eso, en una guerra con ataques diarios, refugiados cruzando fronteras y muertes injustas, se exacerba.

Hasta hace un tiempo, había un “consenso de los conectados” (según Rebecca McKinnon) de la moderación: nos parecía bien que las plataformas tuvieran mecanismo de moderación contenidos ciertamente problemáticos. Coincidíamos en que las compañías tecnológicas debían ocuparse de mantener al entorno en línea protegido de delitos que afectaran la seguridad y la integridad de las personas (pedofilia, violencia sexual, contenidos y situaciones donde aparecen víctimas de todo tipo). Nosotros, los conectados, le dimos una carta blanca a las plataformas para ejercer la moderación. Pero no les preguntamos demasiado cómo lo hacían ese trabajo.

Las plataformas, por su parte, establecieron reglas privadas, sin debates amplios ni rendición de cuentas suficientes. La auto-regulación fue la ley. Entonces empezaron los errores y las omisiones, cada vez más frecuentes: la censura de contenidos sin consulta, la limitación de medios o activistas, el etiquetado abusivo y con motivos desproporcionados.

Confiados en que en las redes concentran los problemas que afectan a la democracia y creyentes de que las plataformas cuentan con mecanismos infalibles, creamos un monstruo. El de unos enormes custodios privados del discurso público con muy poco o nulo control. Pero estamos a tiempo de resolverlo.

Repartir el poder

¿Quién define la independencia editorial, la afiliación estatal o el etiquetado en el caso de las plataformas? En general, son los mismos equipos de las compañías. En algunos casos, como el de Twitter y otras compañías, lo hacen con la ayuda de consejos asesores: organizaciones de la sociedad civil, academia, usuarios digitales. Sin embargo, se requiere todavía ampliar esa participación y esa transparencia, tanto en la composición de esos consejos como de las reglas con las que se opera.

Democratizar el modelo actual de toma de decisiones de las plataformas será, ciertamente, más complejo. Pero si las compañías insisten con mantenerse como las únicas custodias de los espacios online, serán cada día menos capaces de rendir cuentas a una ciudadanía que les está demandando más transparencia (y que es, por otro lado, su consumidor, con derechos).

Se solía decir que las plataformas no necesitan rendir cuentas porque son empresas privadas. Está claro que esa ya no es una excusa. Desde hace tiempo, y a partir del conflicto en Ucrania, hemos visto una espiral de censura sobre derechos humanos básicos como la libertad de expresión. Los mismos tuvieron en las plataformas aliados corporativos desde los cuales realizar boicots y medidas de castigo, tanto desde los países de Occidente como desde Rusia. Ya no es más una discusión de empresas privadas decidiendo cómo manejan sus contenidos.

En la cuestión, todos los países, incluso la Argentina, tenemos algo que decir. Estamos invitados a la conversación (nos inviten o no). Solemos pensar que no tenemos nada que hacer frente a corporaciones tan poderosas. Pero sí tenemos: nuestras propias leyes, la Constitución, la Convención Interamericana de Derechos Humanos, entre otras, contienen instrumentos legales que protegen los derechos de las personas frente a, por ejemplo, la censura o el cercenamiento de la libertad de expresión. No se trata siempre de pensar nuevas regulaciones, sino de abrir la discusión para que, en caso de crisis, pero sobre todo en tiempos de normalidad, los derechos primen por sobre las decisiones arbitrarias.

Cambiar el enfoque es imprescindible. Si hasta ahora la moderación no contó con la suficiente participación, es hora de tenerla: más mujeres, comunicadores para decidir sobre cuestiones de comunicadores, diversidades para pensar sobre diversidades, y así podemos seguir. Las leyes de internet no pueden seguir siendo ni tan privadas ni tan de abogados ni tan de hombres blancos.